168联盟

168联盟全国招募支付合伙人

4.6

多模态支持:支持多种任务类型,包括文本生成、图像生成、语音转文本以及基于扩散模型的文本生成图像,让创作更加自由高效。

CPU推理优化:在安卓设备上,MNN-LLM 展现出卓越的CPU性能。与 llama.cpp 相比,预填充速度提升 8.6 倍,解码速度提高 2.3 倍;相较于 fastllm,预填充速度提升 20.5 倍,解码速度快 8.9 倍,大幅提升推理效率。

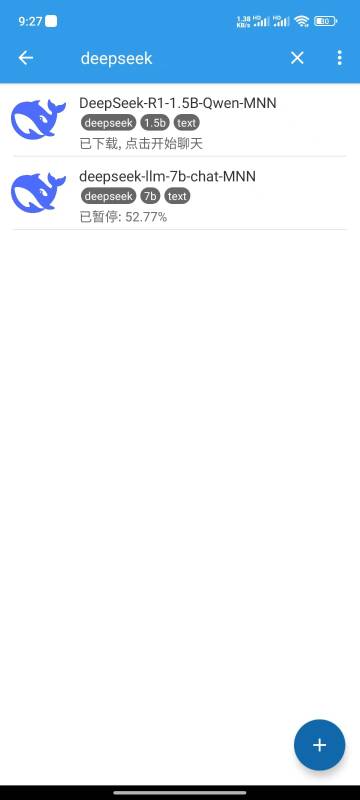

广泛的模型兼容性:兼容众多主流模型,包括 Qwen、Gemma、Llama(TinyLlama 与 MobileLLM)、Baichuan、Yi、DeepSeek、InternLM、Phi、ReaderLM 以及 Smolm,让用户自由选择最适合的模型。

本地运行,保护隐私:所有推理任务均在本地设备上完成,无需联网上传数据,确保用户隐私安全,提供更稳定、可靠的使用体验。